位姿参数辨识系统

1. 绪论

1.1 项目简介

在建设航天强国的道路上,航天器将承担越来越多的任务,未来的航天器会更加复杂,在轨服务技术及空间对抗技术具有显著的战略价值[1]。航天器动力学参数正确辨识是完成任务的重要保障,能够为航天器自身提供所需的控制参数,增强航天器自适应性及智能性[4]。目前,参数辨识主要依靠视觉传感器,视觉测量具有系统简单、成本低、对目标无扰动、非接触、测量参数丰富等特点[6],能够完成传统接触式测量方式无法完成的任务[3]。现有的基于视觉的目标运动参数测量技术,主要是对图像中的目标进行特征提取、图像识别及运动学处理[2]。由于特征点会发生漂移,得到的目标运动参数精度及实时性欠佳,难以满足高精度、快响应的任务需求。因此,研究航天器位姿参数辨识的智能算法有实际意义[5]。

本文旨在设计实现视觉测量求解的位姿参数辨识系统:(1)采用视觉测量方案,实现非接触、低成本的图像采集系统;(2)利用深度神经网络提供更加准确的特征点提取结果;(3)采用PNP位姿解算方法求解,得到位姿参数辨识结果。初步试验结果表明,该位姿参数辨识系统能够较好的满足使用需求,得到精度较高的辨识结果。

1.2 立项背景

在建设航天强国的道路上,航天器将承担越来越多的任务,未来的航天器会更加复杂,在轨服务技术及空间对抗技术具有显著的战略价值。潜在的军事需求主要包含:(1)太空垃圾的清理——对太空垃圾的形状尺寸、位置、速度等运动参数进行测量,为采取合理的垃圾清理方案提供数据依据;(2)在轨航天器的维护及抓捕——对目标航天器的运动姿态及轨迹进行辨识及预测,便于进行补充燃料、更换故障模块、辅助控制等操作;(3)航天器的在轨装配——空间站等大型航天设备难以通过一次发射完成建设,对接过程中的目标定位及姿态确定是必要的技术手段。因此,飞行器位姿参数辨识是完成上述任务的基础且关键的环节之一。

视觉测量具有系统简单、成本低、对目标无扰动、非接触、测量参数丰富等特点,在能够完成传统接触式测量方式无法完成的任务,多用于空间目标。现有的基于视觉的目标运动参数测量技术,主要是通过时间序列上连续拍摄图片的方式,对图像中的目标进行特征提取、图像识别及运动学处理。由于特征点会发生漂移,得到的目标运动参数精度及实时性欠佳,难以满足高精度、快响应的任务需求。随着运算速度的提升,计算机视觉近年来发展迅猛,大规模的数据集和超强的计算能力为结果的精度及可行性提供了保障,深度学习方法得以广泛开展。

目前主流的视觉传感器有以下三种:单目摄像头(Monocular Camera)、双目摄像头(Binocular Camera)、深度摄像头(RGB-D Camera)。深度摄像头可以直接获得图像及其对应的深度信息,但是成本太高,体积较大,不适用于室内环境。双目摄像头可以通过三角方法计算出深度信息,但是双目摄像头在目标距离较远时就会变成单目摄像头。单目摄像头通过临近图像匹配计算出摄像头位姿的变换,在两个视角上进行三角测距得到对应点的深度信息,通过迭代实现定位及建图。相比而言,单目摄像头具有载荷轻、体积小、灵活等优势,本项目采取单目摄像头方式。

综上所述,本项目将研究一种基于单目摄像头的位姿参数辨识系统。

1.3 国内外研究现状

1.3.1 飞行器位姿参数辨识方法研究

空间任务的目标飞行器主要具有以下特性:(1)无法掌握目标飞行器的运动轨迹;(2)不能与目标飞行器进行信息交换;(3)缺乏能够辅助测量的特征或合作标志、。因此,对于空间目标,无法通过内置接触式传感器进行测量。需要通过外置传感器的方式进行测量,目前对空间目标运动运动参数的非接触测量方法主要有:

(1)基于激光成像雷达扫描测量[1]: 激光雷达有着采样频率高、波束窄、工作距离长、受光照影响小、抗干扰等特点。基于激光成像雷达的目标测量技术研究历史悠久,较为成熟,但是存在无法对目标进行高速实时跟踪,不能够连续测量等问题。

(2)基于机器视觉测量[2]: 机器视觉测量有着非接触、体积小、功耗低、能够提供高分辨率图像等优势,是现在研究人员广泛关注的问题。

综上所述,视觉测量技术是近几年新发展的非接触式测量技术,在空间目标抓捕、在轨装配、飞行器姿态测量等诸多领域都具有非常广阔的应用前景和潜在价值。本课题主要开展基于视觉的飞行器运动参数测量方法。

1.3.2 视觉测量的关键问题及研究现状

位姿参数是空间中物体运动状态表征的核心参数,对其进行有效高精度的测量对军事、航天等领域都有重大意义。位姿测量方法分成以下三类:(1)基于目标模型的方法[3]——通过将局部或全部特征与先验模型进行模板匹配,该方法解算精度高、鲁棒性好,但需要先验信息。(2)基于三维点云的方法[4]——通过建立非合作目标表面的三维点云与已知目标三维模型进行迭代配准,该方法精度高但算法复杂、计算量大、实时性差。(3)基于目标特征的方法[5]——通过对目标上的特征进行识别从而估算目标位姿,该方法精度和鲁棒性较差,但是计算量小、实时性高。通过选择合适的特征表示能够大幅的提高精度和鲁棒性,是现在的研究重点。

基于目标特征的视觉测量过程主要可以分为目标检测和位姿解算两个部分,目标检测用来提取被测目标的几何特征或是语义信息;位姿解算根据提取到的目标特征,通过几何变换得到被测目标的位置及姿态信息,下面仅对目标检测方法的研究现状进行综述。

传统的目标检测方法[6],例如 SIFT、HOG和DPM等,这些方法可以通过先验知识来设计合适的识别特征,在特定的场景下,能够达到较高的检测精度,并且速度较快。但是,由于传统目标检测方法特别依赖先验知识,需要通过先验知识对应设计识别特征,不具备适应性和泛化性。

基于深度学习的目标检测方法能够通过输入自适应的提取目标的特征,可以采用预训练,并且能够将训练好的模型应用在不同的场景中,能够有效提高模型的泛化性。

根据分类回归与区域提取是否分开,基于深度学习的目标检测模型可以分为基于回归的目标检测模型和基于区域候选的目标检测模型。

(1)基于回归的目标检测模型[7]:基于回归的目标检测方法是根据特征映射图预先划分默认框,根据默认框对目标进行分类,典型的回归目标检测方法有YOLO、SSD及相应的改进算法等,以上算法均采用回归的思想,先提取边界的回归框,再进行迭代。基于回归的目标检测算法的优点是检测速度快,但是检测精度较差;

(2)基于区域候选的目标检测模型:基于区域候选的目标检测方法首先是对特征映射图进行边界框提取,然后再将边界框提取结果与特征映射图一起输入至感兴趣区域的池化层,实现对目标分类和定位。基于区域候选的目标检测算法的优点是检测精度较高,但是速度较回归模型慢。

R-CNN[8]模型是将深度学习区域候选方法引入目标检测任务的开创者,能够实现目标的自适应检测。在R-CNN的基础上,SPP-net[9]在R-CNN中引入了空间金字塔池化层,检测精度有所提升。Fast R-CNN[10]在SPP-net的基础上进行优化,检测速度加快。Faster R-CNN[11]算法在Fast R-CNN的基础上进行改进,在提取候选区域的过程中引入了区域建议网络,从而实现了端对端的训练,极大地提高了候选区域提取的精度以及网络训练的速度。Mask R-CNN[12]改进Faster R-CNN中的感兴趣区域池化层为感兴趣区域对齐,并且采用“双线性插值法”,有效降低了边界回归框的位置误差。此外,Mask R-CNN算法生成了掩膜,能够完成实例分割任务。

1.4 项目研究内容及意义

本课题重点开展基于机器学习的航天器位姿参数辨识算法研究,并搭建仿真及地面试验系统展开验证,首先,利用相机阵采集不同角度的模拟卫星的图像,构建训练数据集;其次,利用语义分割算法划分目标图像块,提取关键点,进而解算目标位姿;最后,与传统方法得到的位姿结果进行比较,分析测量精度。主要研究内容如图1所示。

在对项目需求和研究现状分析的基础上,本文给出可一种基于机器学习算法的位姿参数智能辨识系统设计方案。主要采用单目摄像头进行图像采集,利用深度神经网络进行图像关键点提取,利用PNP位姿解算方法得到位姿参数辨识结果。

1.5 参考文献

陈凤,朱洁,顾冬晴,王盈,刘玉. 基于激光成像雷达的空间非合作目标相对导航技术[J]. 红外与激光工程,2016,(10):202-208.

王珂,陈小梅,韩旭. 具有同心圆特征的非合作目标超近距离姿态测量[J]. 光电工程,2018,45(8):180-183.

杨阳. 基于模型的双目位姿测量方法研究与实现[D]. 西安电子科技大学:2015,12.

杨帆. 基于点云融合的双目线结构光三维测量系统的研究与应用[D]. 华南理工大学:2018,4.

于占海. 面向非合作目标的双目视觉运动估计及三维重构方法研究[D]. 哈尔滨工业大学:2017,6.

卢湖川,李佩霞,王栋. 目标跟踪算法综述[J]. 模式识别与人工智能2018, (1) :30-33.

黄杰军,呼吁,周斌,明德列. 基于改进YOLO的双模目标识别方法研究[J]. 计算机与数字工程,2018,4(342):808-811.

Ross Girshick, Jeff Donahue, Trevor Darrell, Jitendra Malik. Rich feature hierarchies for accurate object detection and semantic segmentation[J]. In CVPR, 2014,10,22.

KaimingHe,Xiangyu Zhang, Shaoqing Ren, Jian Sun. Spatial Pyramid Pooling in Deep ConvolutionalNetworks for Visual Recognition[J]. In ECCV, 2014.

Ross Girshick. Fast R-CNN[J]. In ICCV, 2015,9,27.

Shaoqing Ren, Kaiming He, Ross Girshick, and Jian Sun. Faster R-CNN: Towards Real-Time Object Detection with Region Proposal Networks[J]. In IEEE, 2016,1,6.

Kaiming He, Georgia Gkioxari, Piotr Dollar, Ross Girshick. Mask R-CNN[J]. In IEEE, 2018,1,24.

白宝林. 基于改进的Mask R-CNN的车辆识别及检测[D]. 安徽大学:2018,4.

Rublee E, Rabaud V, Konolige K, et al. ORB: An efficient alternative to SIFT or SURF[C] IEEE International Conference on Computer Vision. IEEE, 2012:25642571.

王鹏,赵汗青,王江峰,刘红彬,陈伟. 基于单目视觉的相机位姿计算[J]. 电子科技,2017, 12(5):75-78.

2. 项目方案

基于机器学习算法的位姿参数辨识系统主要利用图像处理及参数解算的相关理论,实现对非合作航天器进行特征提取、特征匹配、位姿解算等,研究工作主要包含以下三个方面:

(1)相机测量模型及相机标定,采用单目摄像头采集图像信息,需要考虑当前的环境信息,对相机进行参数标定,得到较为准确的相机模型。

(2)深度神经网络训练及关键点提取,构建深度神经网络,针对性进行参数训练,得到鲁棒性较好的网络和关键点提取结果。

(3)位姿参数解算,利用PNP位姿参数解算算法,输入测量到的特征点坐标值,得到相对位置及转角参数辨识结果。

2.1图像采集系统设计

2.1.1坐标系定义

2.1.2 坐标系转换关系

(1)图像物理坐标系转换相机坐标系

相机坐标系到图像物理坐标系属于透视投影关系,使用针孔相机模型,从3D转换到2D,满足三角形相似原理,如图4所示。

(2)世界坐标系转换图像像素坐标系

根据上述坐标系的变化关系可得公式:

2.1.3 相机标定方法

相机标定方法有:传统相机标定法、主动视觉相机标定方法、相机自标定法。

传统相机标定法需要使用尺寸已知的标定物,通过建立标定物上坐标已知的点与其图像点之间的对应,利用一定的算法获得相机模型的内外参数。根据标定物的不同可分为三维标定物和平面型标定物。三维标定物可由单幅图像进行标定,标定精度较高,但高精密三维标定物的加工和维护较困难。

目前出现的自标定算法中主要是利用相机运动的约束。相机的运动约束条件太强,因此使得其在实际中并不实用。利用场景约束主要是利用场景中的一些平行或者正交的信息。其中空间平行线在相机图像平面上的交点被称为消失点,它是射影几何中一个非常重要的特征,所以很多学者研究了基于消失点的相机自标定方法。自标定方法灵活性强,可对相机进行在线定标。但由于它是基于绝对二次曲线或曲面的方法,其算法鲁棒性差。

基于主动视觉的相机标定法是指已知相机的某些运动信息对相机进行标定。该方法不需要标定物,但需要控制相机做某些特殊运动,利用这种运动的特殊性可以计算出相机内部参数。基于主动视觉的相机标定法的优点是算法简单,往往能够获得线性解,故鲁棒性较高,缺点是系统的成本高、实验设备昂贵、实验条件要求高,而且不适合于运动参数未知或无法控制的场合。

本文主要采用张正友标定法,一种利用平面棋盘格进行相机标定的实用方法。该方法介于摄影标定法和自标定法之间,既克服了摄影标定法需要的高精度三维标定物的缺点,又解决了自标定法鲁棒性差的难题。标定过程仅需使用一个打印出来的棋盘格,并从不同方向拍摄几组图片即可,任何人都可以自己制作标定图案,不仅实用灵活方便,而且

2.2深度神经网络设计

本文采用Mask R-CNN网络模型[8],网络结构图如图5所示。

.

.

输入一张任意大小的图片进入Mask R-CNN网络后,深度卷积网络会完成两个任务,一是通过Faster R-CNN的RPN网络挑选候选区域;二是进行目标检测操作。相比于Faster R-CNN算法,Mask R-CNN改进主要有两点,首先是,将感兴趣区域池化层改成了感兴趣区域对齐操作,主要是因为分割基于像素操作,而感兴趣区域池化过程中存在四舍五入量化,使得像素的输入和输出不一一对应[9]。

感兴趣区域对齐直接将特征图划分并采用双线性插值,能够保证池化过程中像素在前后输入的一一对应关系。

在回传过程中,进行反向传播[12],见公式(1):

Mask R-CNN在Faster R-CNN原有框架基础上增加了掩码,能够对每个感兴趣区域进行实例分割操作。

则,对于每个感兴趣区域可以得到的平均得分为公式(3):

Mask R-CNN主要是采取了并联网络层,将主干网络中的特征提取层与掩码层并联能够增强网络的泛化能力。并且因为金字塔网络具有横向连接的自顶向下结构,可以提取不同级别的感兴趣区域特征,并联后可以把高层特征带到低层次去,低层次既有语义又存在细节。

Mask R-CNN算法步骤[10]:

(1)输入一幅待检测的图片,进行预处理操作;或者直接输入预处理后的图片;

(2)输入到预先训练好的神经网络中获得对应的特征图;

(3)对特征图中的每一个点设定预定个兴趣区域,从而获得多个候选兴趣区域;

(4)将候选兴趣区域送入区域建议网络进行二值分类和回归,筛洗部分候选的兴趣区域;

(5)对剩下的兴趣区域进行对齐操作,即将原图的特征与固定的特征进行匹配;

(6)最后,对兴趣区域进行分类、回归、标签生成。

2.3位姿解算系统设计

单目视觉的位姿测量是根据特征点在空间坐标系的坐标值和其投影到相机上特征点,由摄像机投影模型,计算出空间坐标系相对于摄像机坐标系的相对位置和姿态。

2.3.1 空间坐标求解

利用特征点投影的二维图像点计算空间点在摄像机坐标系下三维坐标值,可以利用三角形的余弦定理来求解,如图6所示。

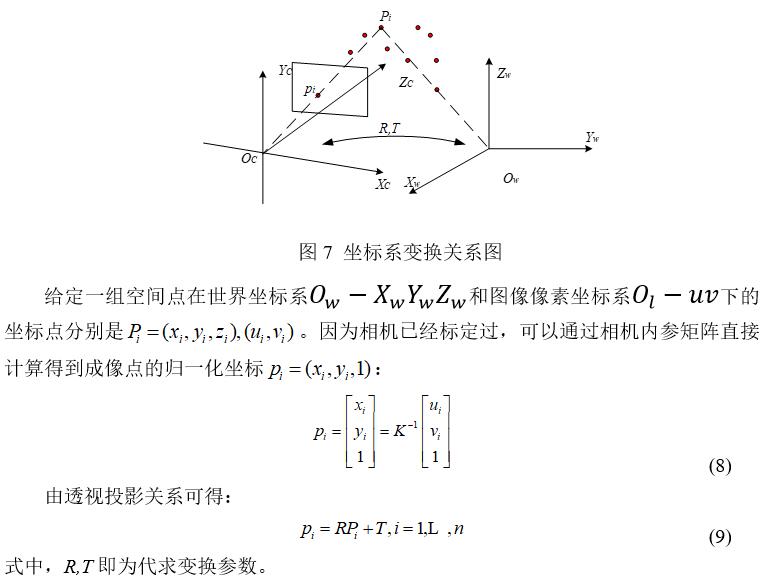

2.3.2 坐标系变换关系解算

根据空间点在摄像机坐标系下坐标值和标定好的空间点在空间坐标系下坐标值,就可以计算出空间坐标系和摄像机坐标系之间的相对姿态和相对位置,如图7所示[14]。

3. 项目实施及成果

3.1 相机标定结果

3.1.1 仿真模型相机标定结果

利用gazebo仿真环境建立相机模型,在平面上方0.5m位置处建立一个相机模型,相机朝向向下,像素为640*480,每个像素8位,在平面上放置7*8棋盘格标定板,(相机模型如图8所示),并使用calibration标定方法进行标定,标定过程如图9所示。

3.1.2 实物摄像头标定结果

采用calibration对外置USB单目摄像头进行标定,摄像头实物图如图10所示。输入图像像素大小为640*480,标定过程图如图11所示。

3.2 神经网络训练结果

我们采用了Mask R-CNN成熟网络结构,应用预训练权重mask_rcnn_coco.h5,在它的基础上进行权重微调,在仿真环境中采集50帧图像,对空间目标进行标注,迭代250次,得到新的权重,进行检测。

3.3 位姿参数解算结果

位姿解算流程图如图17所示,输入相机内参矩阵及畸变系数,提取匹配后的2D特征点以及对应的3D坐标值,求解相机姿态计算欧拉角及坐标值,输出相对位置及转角[17]。

3.4初步实验结果

利用传统方式和深度学习两种方式进行特征点匹配和位姿解算,取第一帧图像上的左太阳帆板左上角为世界坐标系原点(0,0,0),并已知模型外形尺寸。在软件上操作仿真模型摆出相应姿态,记为理论值;分别采用传统和深度学习两种方式得到的关键点进行位姿解算,位姿解算结果图如图18-23所示。

虚线是理论值,绿色为传统方法测量值,红色为深度学习方法测量值,传统方法和深度学习两种方法解算出的位姿结果与理论值都大致吻合。但是传统方法在第七帧出现了坏点,可能存在特征误匹配现象,深度学习方式暂未发现误匹配点。深度学习方法较传统方法与理论值的差距更小,与理论值更加吻合,因此可以得出结论,在空间目标的特征提取和位姿解算任务上,深度学习方法比传统方法在准确性方面上要更好一些。

4. 研究结论

本文主要研究了空间目标位姿参数测量问题。空间目标具有模型未知,不能依靠本体传感器,不能进行信息交互等特点,对其进行动力学参数测量需要应用外部测量手段。基于机器视觉的测量方法具有体积小、非接触、成本低等优点,现在是空间中的主要测量方式之一。本文基于机器视觉对空间目标进行了位姿参数辨识,并进行了相关实验及对比分析。

本文得到的主要研究成果如下:

(1) 相机模型建立及相机标定

介绍了相机测量模型包含坐标系定义、刚体变换参数表示、相机成像模型、坐标系相互转换关系等,并在仿真环境和实物相机分别进行了相机标定。

(2)基于深度神经网络的空间目标语义分割及关键点提取

构建了深度学习方法进行语义分割及关键点提取网络,利用仿真环境搭建的动力学模型得到空间目标图片,在预训练权重的基础上进行微调,使其能够对空间目标进行图像语义分割及关键点提取。

(3)空间目标位姿解算算法

构建了两种位姿估计方法:基于传统方法的位姿解算算法和基于深度学习的位姿解算算法。实验结果表明,两种方式均可以实现位姿参数的测量,传统方法速度更快,深度学习方法解算精度更高。

分享让更多人看到

推荐阅读

相关新闻

- 评论

- 关注

第一时间为您推送权威资讯

第一时间为您推送权威资讯

报道全球 传播中国

报道全球 传播中国

关注人民网,传播正能量

关注人民网,传播正能量