互联网新闻标题生成方法研究

摘要:

近年来,网络新闻的“震惊体”文不对题现象层出不穷,为保证更加高效准确的信息检索及用户体验,本文探讨图结构、编解码器、注意力机制下编解码器以及指针生成器四种方法应用于新闻标题生成任务中的可行性。指针生成器模型根据原文词先验分布抽取及高维语义信息生成两种方式联合所生成的新闻标题在语义上较为完整,表达较为准确。

关键词:“震惊体”,自然语言生成、新闻标题、编解码器

一、引言

随着web2.0的快速发展,以人民网、微信、微博为代表的新兴媒体加速崛起。此前,国家新闻出版广电总局印发的《关于进一步加快广播电视媒体与新兴媒体融合发展的意见》提出要大力推广传统广电媒体与新兴互联网媒体深度融合、一体共生。在这样的时代背景和政策导向引导下,人们发布和获取新闻内容的途径发生了天翻地覆的变化,逐渐由传统媒体转向网络新兴媒体。同时大量的新兴媒体的普及也引发了互联网媒体上的新闻内容爆炸式增长。

人民网作为世界十大报纸之一《人民日报》建设的以新闻为主的大型网上信息发布平台,每日收稿量巨大。然而,这些稿件新闻内容质量良莠不齐,其中不乏一些选取华丽标题却缺乏实质内容的“标题党”文章浪费了审稿人员大量的时间精力,如何快速的获取文章的真实主旨成为了审稿人员的重要能力。除了人工的加强审稿能力外,人工智能技术,尤其是自然语言处理技术将极大的助力新闻主旨检索。本文讨论通过标题再生成的方法,生成最贴切新闻文章内容的新闻标题,未来希望通过此方法来减少人工排查“标题党”的时间。

目前的新闻检索大多采用搜索引擎加关键字权重的方法,忽略了文章的内涵。因此,如何根据新闻内容生成言简意赅的新闻标题是一项具有挑战性的研究课题。近年来,随着国内外学者在自然语言处理领域的不断深入研究,相关理论体系和实作方法论的不断进步,使得对文本的智能理解和挖掘技术愈加成熟。文本摘要就是一类运用自然语义处理方法,帮助机器理解冗长自然语言文本内容,并生成一些简短、精炼高度概括文本内涵的句子的技术。除了直接呈现文本摘要结果给用户阅读外,文本摘要技术还在很多下游任务中充当着重要角色,如长文本情感分析、搜索引擎、推荐系统等。相比于直接使用原文,使用好的摘要能够在提升性能的同时又尽少的造成信息损失。新闻标题生成可以看成文本摘要技术的一种应用场景。由于新闻结构的特点、标题一般而言都是非常简练、甚至有点抽象、高度概括文章内容的句子。文本摘要技术作为一种重要的自然语言处理技术,对于快速获取和更好展示新闻内容具有重要的意义,这也是本文的研究意义所在。

二、研究现状

随着自然语言处理技术的进步,越来越多的研究在自然语言生成任务(NLG)上取得了明显进步。根据输入信息的不同,NLG可分为:数据到文本的生成、文本到文本的生成、意义到文本的生成、图像到文本的生成等。 因本文意在讨论根据新闻文本生成新闻标题的NLG技术,属于“文本-文本”生成,故下文着重讨论此技术相关方法。文本-文本生成技术用于智能聊天、文章自动摘要、文章自动生成标题等问题都有着广阔前景。近年来,许多优秀的研究着力于提升文本生成的准确、流畅程度。文章标题是精炼的文章内容,其使用最简短的语言最大限度的反应文章的主要内容。标题自动生成算法根据其选择、组织语言的方式可分为抽取式方法和生成式方法。

抽取式方法依据文本的统计信息提取关键的词、句的排序并重新组合成为标题,Luhn[1]是最早使用主题词法的研究员之一,他们使用频率阈值来定位文档中的描述性词语并表示文档主题。Dunning[2]提出了一个更高级的概念,他们使用对数似然比检验来识别解释性词语,在总结文献中称之为“主题签名”。利用主题签名词作为主题表示非常有效,提高了新闻领域多文档摘要的准确性[3]。Vanderwende等人[4]提出一个名为sumbaic的系统,该系统仅使用单词概率权重的逐步迭代方法来确定句子的重要性,进而生成标题。TFIDF权重在单词概率基础上进行改进,利用词频和反转词向量计算重要性,具有计算简单、快速的优点。工作[5-7]的共组基于这种方法取得了不错的效果。Gong等[8]提出了一种基于lsa的新闻领域单文档和多文档摘要高排名句子选择方法,该方法对每个主题都选取一个最高得分的句子,最后根据所需要生成的限定长度保留主题的数量。Henning等人[9] 提出一种将句子映射到本体概念的句子提取方法。通过考虑本体特征,可以提高句子的语义表达,有利于总结句子的选择。

生成式方法则是通过对全文的语义分析,经由特征变换得到词、句、段的高维表示,进而依据语义生成相应的标题,区别于抽取式方法,生成式方法对标题的选词可能是文章中从未出现过的新词。其中传统算法,包括基于树结构、基于模板、基于语义、基于图等的方法都取得了较好的结果。在基于树结构方法框架中,算法根据如谓词-论据结构[10]、依赖树[11]等方式提取摘要要考虑的重要文本。然后,使用浅层解析器从文本中识别出相似的句子。类似的句子被填充到树状结构中。在基于模板的方法中,依赖于文本深层的句法和语义分析[12],使用预定义的模板结构有助于创建简洁、连贯的摘要。但是,由于规则和模式是手动定义的,因此这类方法非常耗时,还需要大量手动操作[13]。基于语义的自然语言生成方法首先通过查找信息项、谓词参数结构或创建语义图来获得文本的语义表示。通过编辑谓词-论据距离度量等相似性度量从中发现语义相似的结构,并通过k-均值或层次聚类等方法将语义相似的结构合并在一起[14]。然后,将此表示形式输入自然语言生成系统。基于语义图的方法通过把文本分割成若干组成单元(如单词、句子等)并建立图(节点-边)模型, 利用投票机制对文本中的重要成分进行排序, 仅利用单篇文档本身的信息即可实现关键词的提取、文摘。随着深度学习的兴起,以Sequence-to-sequence神经网络结构为框架的深度学习模型开始在文章标题、文章摘要等方向崭露头角。Chopra[15]等人使用RNN及其变种LSTM构成编码器-解码器结构来生成文章总结,Jobson[16]等人,在使用编-解码器结构的同时利用注意力机制提取重要词,取得了更优秀的结果。Song[17]等人以短语替代单词作为输入,经由LSTM组成的编解码结构来生成文章简介.Abigail[18]等人在解码器端进行了改进提出了pointer-generaer网络,通过指针从源文本复制单词,提高了OOV单词的准确性和处理能力,同时保留了产生新词的能力。

三、相关模型

3.1、 基于图计算的自然语言生成方法

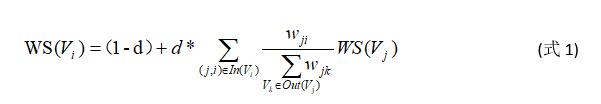

TextRank 可以表示为一个有向有权图 G =(V, E)。该图由点集合 V和边集合 E 组成,其中,E 是V × V的子集,图中任意两点 Vi , Vj 之间边的权重为 wji 。 对于任意一个给定点 Vi ,In(Vi) 为 指 向 该 点 的 点 集 合 , Out(Vi) 为点 Vi 指向的点集合。点 Vi 的得分定义如下:

其中, d 为阻尼系数, 取值范围为 0 到 1, 代表从图中某一特定点指向其他任意点的概率。使用TextRank 算法进行图计算时,对图中的节点得分进行随机初始化,并递归计算直到收敛(图中任意一点的误差率小于给定的阈值)

3.2基于深度学习的自然语言生成方法

(1) 编码-解码器(encoder-decoder)介绍:

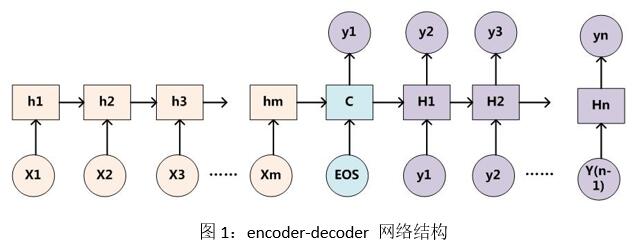

encoder-decoder是一种经典的seq2seq结构。它能够实现将一个序列转换到另一个序列,并且不要求转换的两个序列等长,十分适合文本摘要任务。而类似自然语言文本这种序列数据都存在这时序关系,因此seq2seq常常使用LSTM,GRU这种能够有效缓解梯度消失问题的神经网路结构来建模。具体网络结构如图1所示:

在这幅图中,encoder端接收文本序列[x1:xm]的词向量表示作为输入,词向量可以由word2vec、glove、BERT等语言模型训练得到。encoder端把文本内容编码成一个固定大小的理论上包含全文信息的隐层向量C,C的计算公式如式2所示。

要找到最优最大概率的摘要序列Y,有两种方法可以选择,一种式基于贪心搜索算法,即在每一步都选取概率最大的单词作为输出。这是一种最低成本的方法,但是这种方案得出的结果未必是最优的。因为当前时间步的解码输出会影响之后的解码输出。累计乘积可能并非最高。另一种方法则是枚举所有输出序列并计算得分,这种方法一定能找到全局最优解,但是时间复杂度和空间复杂度过高,实用性不强。因此Seq2Seq使用了一种这种的方法beam search。这种方法是贪心搜索和暴力枚举的这种方案。在每个时间步内保留topk个最优候选结果,它本质还是属于贪心算法的范畴,只不过在贪心的过程中保留了更多可能。

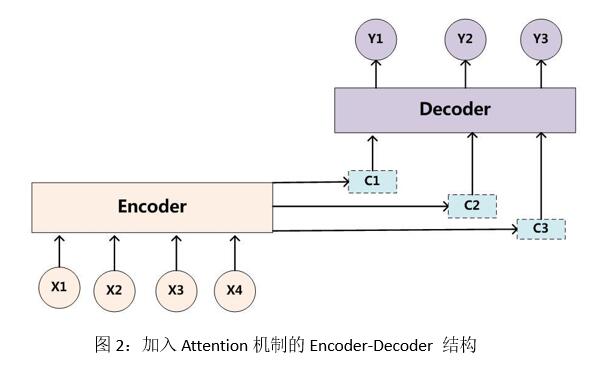

(2)注意力机制下跌的编码解码器结构(Attention based encoder-decoder)

单纯的编-解码器结构有一个显著的缺点,就是整个编码-解码过程共享一个单独不变的语义编码C,对于不同的生成词都使用同一个C造成的结果就是模型不会根据当前生成词位置的不同而采取不同的采样方式。而Attention机制在整合encoder-RNN不同时间步生成encoder的隐藏状态的序列时,输出解码的状态St。及相应attention权重α。

至此,算法可达到收敛。其模型结构如图2所示:

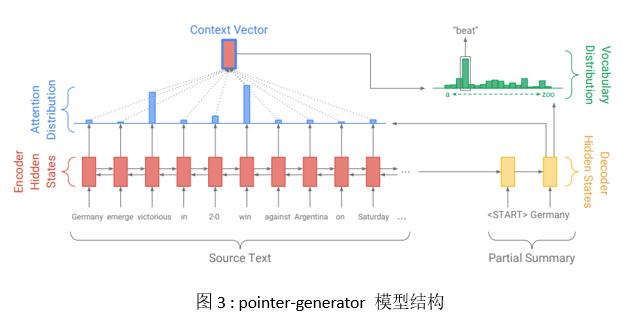

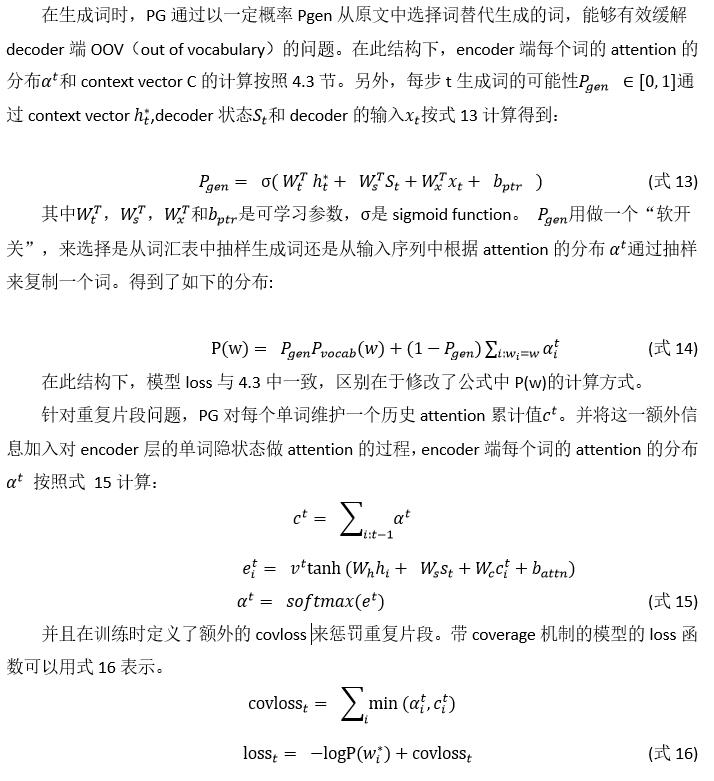

(3) pointer-generator

传统的Seq2seq在生成摘要的每一个单词时,通过一个softmax层计算词汇表中每一个单词的得分。即生成的摘要一定是来自于词表里面有的单词,而在模型训练之前,这个词表已经是确定了的。因此训练出来的模型在文中遇到词表中没有的词却又是非常关键的细节词时会出现细节表述不清的问题。这也就是集外词(OOV)问题。此外,由于解码时只看见前一个时刻的解码出来的单词,因此非常容易生成重复的摘要片段。针对传统文本摘要模型存在的这两个问题,Abigail See等基于传统的attention-based encoder-decoder模型结构做了修改提出了pointer-generator模型(以下简称PG模型)。一方面,PG模型引入pointer指针来按一定概率从原文中复制某些单词作为摘要。另一方面,引入coverage机制,在生成词时,增加对每个词历史累计attention得分的惩罚。作者认为之前出现过词在摘要中再次连续出现的概率应该要降低。PG的模型结构如图3所示:

四、实验方法

本文基于互联网上公开的标准新闻数据。通过利用上述研究的文本摘要模型,进行智能互联网新闻标题生成实验,为新闻内容的快速获取和有效展示提供可行的方案。

4.1 数据集构建

我们使用公开数据集ION dataset[19],由于ION数据集原文部分使用原文url链接而非原文文本,我们遵守url链接网站robots协议爬取了相对应的文本。新闻文章-标题共计66518条,格式如表1中所示:

4.2 数据处理

数据预处理是机器学习领域相关工作必不可少的环节之一,在文本数据预处理中,主要工作是消除无意义的特殊字符、常见的无意义或欠意义的词(a, the 等)以及分词来降低数据中的噪声以达到最优的模型效果。在本文工作中,因文本主要通过爬虫爬取,其中包含有许多HTML页面中的标记符号以及表情符号,我们使用正则匹配的方式进行了噪声过滤。分词在中文领域是非常重要的环节,但由于本文使用英文公开数据集,英文单词由空格切分,无需进一步设计分词算法。

最大截断句长是NLP任务中为了保证输入的批次数据一致性而产生的超参数之一,即设定最大截断句长后,所有文本中大于截断句长的部分需要舍弃。在本文选用的数据集中,文章篇幅偏长(2000-3000字左右,如图4所示),方差偏大(最大值30000字)。在深度学习算法的模型输入数据中,批量的结构化数据以矩阵的形式输入到模型中,每一批次中的各条数据必须符合相同的形状(shape)才能够集体约束模型收敛。所以合理的最大截断句长分析是必不可少的,图4中展示了以一个单词为1单位计算的文章长度和标题长度的对比分析,以覆盖95%的截断策略来说,最佳阶段长度应在5000附近,但考虑到新闻文本的特殊性--新闻文本普遍在文章开头部分直入主题,我们对最大长度的截断策略进行了变化,选择以平均值附近的句长来进行截断,其中,文章最大长度为2000, 标题最大长度为25。

文本向量化方法将文本形式的数据转换成具有语义信息的向量形式用以进行建模计算,有one-hot、tf-idf值、word2vec算法、glove算法等进行编码的方式。但是,One-hot编码采用词袋模型,不考虑词与词之间的顺序,并假设词与词相互独立,损失了部分语义信息,还会得到一个离散稀疏的特征矩阵,十分浪费内存,tf-idf, word2vec,glove算法都渴望通过设计一套算法来递归的计算出最能代表词的向量,但人为设计的算法计算出的向量结果表示能力受限于算法原理,故在本文中,我们采用在模型中设置可训练的、随机初始化参数的词嵌入层的方式,利用模型自动训练出一个具有最佳表示能力、最贴合本文选取的语料的词向量输入。

4.3 模型参数

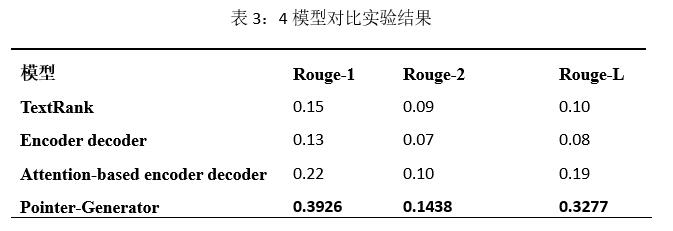

4.4 实验结果

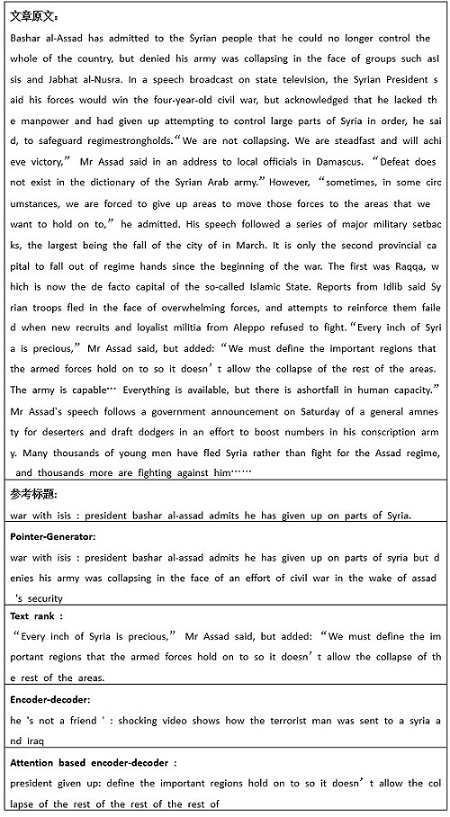

结果表明Pointer-Generator在新闻标题生成任务中具有显著的优势。

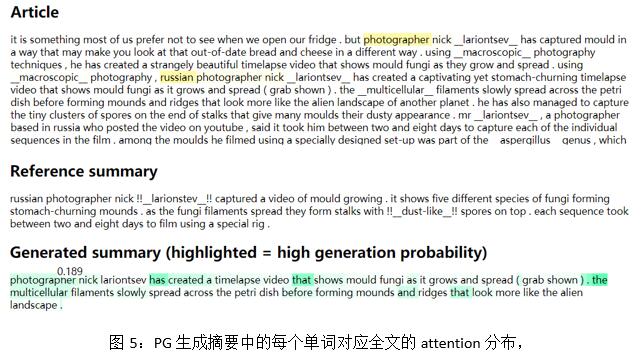

图5是PG生成摘要的每个单词对应全文的attention分布,以及每个单词的P_gen概率。从图中可以看出,当生成摘要的第一个词Photographer时,模型将绝大部分注意力放在原文中的photographer、russian、photographer、nick这四个单词中并以0.189的P_gen概率生成了摘要的第一个词。这表明PG模型具备发现文本细节的能力,并能够理解文章内容之间的关联从而能够达到最佳的标题生成能力。

五、结论

本文切入当今互联网新闻领域文不对题,新闻快速获取和稿件审核困难的痛点。结合当下的自然语言技术发展现状,沿着文本摘要技术的发展脉络,介绍了文本摘要模型的两类基本方法论即基于图结构模型和基于深度学习的模型。并介绍了基于深度学习的文本摘要模型的几处比较新颖的改进。最后通过爬取新闻网站上的真实互联网新闻数据,进行了多模型的新闻标题生成对比实验。最后的实验结果表明基于pointer-generator模型的新闻标题生成结果最为理想,能够有效地应用到海量互联网新闻地标题生成应用中。同时,现有的文本摘要技术仍然存在一些不太完善的问题,如模型更易于生成长句,且重复现象仍然存在。

应用新闻标题生成方法生成的“有效标题”能够较为高效的减少人工审核稿件时间,然而,为了彻底解决“震惊体”现象排查繁琐的问题,“有效标题”与“震惊体标题”的对比检测必不可少,本文暂时着重讨论有效标题的生成方法,在后续工作中,将着重探讨对两种标题的检测部分。

参考文献

[1] Hans Peter Luhn. 1958. The automatic creation of literature abstracts. IBM Journal of research and development 2, 2 (1958), 159–165.

[2] Ted Dunning. 1993. Accurate methods for the statistics of surprise and coincidence. Computational linguistics 19, 1 (1993), 61–74.

[3] Sanda Harabagiu and Finley Lacatusu. 2005. Topic themes for multi-document summarization. In Proceedings of the 28th annual international ACM SIGIR conference on Research and development in information retrieval. ACM, 202–209.

[4] Lucy Vanderwende, Hisami Suzuki, Chris Brockett, and Ani Nenkova. 2007. Beyond SumBasic: Task-focused summarization with sentence simplification and lexical expansion. Information Processing & Management 43, 6 (2007), 1606–1618.

[5] Rasim M Alguliev, Ramiz M Aliguliyev, Makrufa S Hajirahimova, and Chingiz A Mehdiyev. 2011. MCMR: Maximum coverage and minimum redundant text summarization model. Expert Systems with Applications 38, 12 (2011), 14514–14522.

[6] Rasim M Alguliev, Ramiz M Aliguliyev, and Nijat R Isazade. 2013. Multiple documents summarization based on evolutionary optimization algorithm. Expert Systems with Applications 40, 5 (2013), 1675–1689.

[7] Günes Erkan and Dragomir R Radev. 2004. LexRank: Graph-based lexical centrality as salience in text summarization. J. Artif. Intell. Res.(JAIR) 22, 1 (2004), 457–479

[8] Yihong Gong and Xin Liu. 2001. Generic text summarization using relevance measure and latent semantic analysis. In Proceedings of the 24th annual international ACM SIGIR conference on Research and development in information retrieval. ACM, 19–25

[9] Leonhard Hennig, Winfried Umbrath, and Robert Wetzker. 2008. An ontologybased approach to text summarization. In Web Intelligence and Intelligent Agent Technology, 2008. WI-IAT’08. IEEE/WIC/ACM International Conference on, Vol. 3.IEEE, 291–294.

[10] Sunitha, C., Jaya, A., & Ganesh, D. A. (2016). A study on abstractive summarization techniques in indian languages. In Fourth international conference on recent trends in computer science and engineering (pp. 25–31).

[11] Barzilay, R., & McKeown, K. R. (2005). Sentence fusion for multidocument news summarization. Computational Linguistics, 31(3), 297–327.

[12] Oya, T., Mehdad, Y., Carenini, G., & Ng, R. (2014). A template-based abstractive meeting summarization: Leveraging summary and source text relationships. In Proceedings of the 8th international natural language generation conference (pp. 45–53).

[13] Alshaina, S., John, A., & Nath, A. G. (2017). Multi-document abstractive summarization based on predicate argument structure. In International conference on signal processing, informatics, communication and energy systems (SPICES) (pp. 32–37). doi:10.1109/SPICES.2017.8091339.

[14] Alshaina, S., John, A., & Nath, A. G. (2017). Multi-document abstractive summarization based on predicate argument structure. In International conference on signal processing, informatics, communication and energy systems (SPICES) (pp. 32–37). doi:10.1109/SPICES.2017.8091339.

[15] Chopra, Sumit, Michael Auli, and Alexander M. Rush. "Abstractive sentence summarization with attentive recurrent neural networks." Proceedings of the 2016 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies. 2016.

[16] Jobson, E., & Gutirrez, A. (2018). Abstractive text summarization using attentive sequence-to-sequence rnns. Stanford Reports.

[17] Song, S., Huang, H., & Ruan, T. (2018). Abstractive text summarization using lstmcnn based deep learning. Multimedia Tools and Applications, 1(6), 53–57. doi:10. 1007/s11042-018-5749-3.

[18] See, Abigail, Peter J. Liu, and Christopher D. Manning. "Get to the point: Summarization with pointer-generator networks." arXiv preprint arXiv:1704.04368 (2017).

[19] Hollink L , Bedjeti A , Vanharmelen M , et al. A corpus of images and text in online news[J]. 2016.

分享让更多人看到

推荐阅读

相关新闻

- 评论

- 关注

第一时间为您推送权威资讯

第一时间为您推送权威资讯

报道全球 传播中国

报道全球 传播中国

关注人民网,传播正能量

关注人民网,传播正能量