基于在线自适应多重外观模型的长期视频跟踪模型【2】

6. 跟踪算法

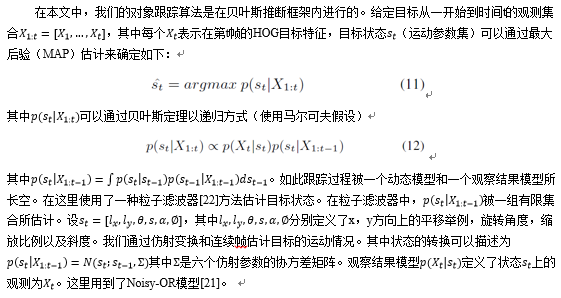

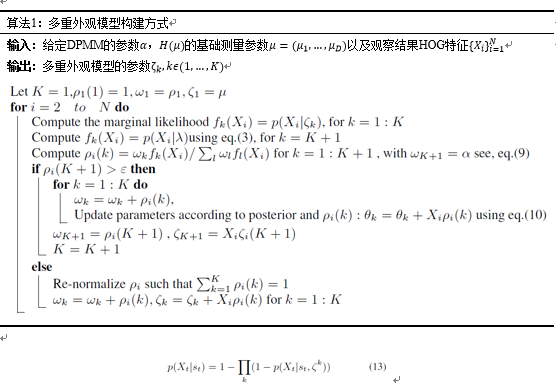

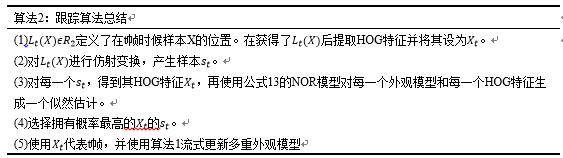

其中ζ_k,k?(1,…,K)表示从算法1学习的多个外观模型参数。上述等式具有一个理想的性质,即如果外观模型中的一个具有高概率,则所得到的概率也将很高。算法2说明了我们的跟踪算法的基本流程。

图2显示了在线自适应多重外观模型如何工作。这些面部图像展示属于每个外观模型的外观实例和跟踪时的历史实例。其中红色矩形是基于我们提出的模型的跟踪结果,绿色矩形是真实结果。随着新的跟踪观测到达,外观模型的数量发生变化。

7. 实验

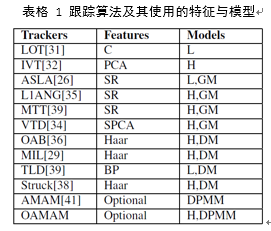

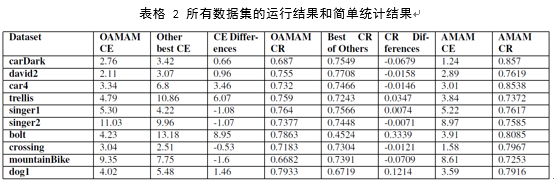

为了评估我们的跟踪器,我们将本文提出的跟踪器在CVPR2013 OOTB提供的10个具有挑战性的公共目标跟踪问题数据集[28]上与10种最先进的算法进行比较。当评估跟踪器时,有几个问题应该讨论。同时,我们采用了CVPR2013 OOTB提出的一些评估方法[28]。在实验中,我们使用10个跟踪器作为基准算法。因为目标跟踪是计算机视觉中的经典问题,各类算法研究的比较多,所以这些跟踪器具有不同的框架,使得当遇到像遮挡等不同挑战时,它们都具有长处和不足。表1展示了所有跟踪器(包括我们提出的算法)的细节。值得注意的是,在我们提出的算法中,HOG特征可以被其他特征代替。

有一点需要强调的是,所有的跟踪器都经过参数调优或者直接使用其发布者给出的参数公平地进行评估。

如前所述,跟踪器在实际使用中可能会遇到一些问题和挑战。根据[40]和[28],我们将这些变化分为六组,并使用以上挑战分析一些数据集。 如表3所示,我们采用10个视频序列作为测试数据集。 在表3中,我们还在每个数据上添加每个挑战的简写形式。这里,OCC表示遮挡,IV表示照明变化,R包含平面旋转和立体旋转的旋转,SV表示缩放变化,而BC表示背景干扰。

注意在这里并没有包括所有目标跟踪可能出现的挑战而只列举了一部分。

我们的算法原型系统是在Matlab上实现的。由于我们没有为跟踪任务指定某种特征,所以我们简单地使用HOG特征来与其他最先进的跟踪器进行比较。注意,更改特征可能会有利于某些数据集的测试结果。

在目标跟踪的评估中,通常使用中心位置误差以及重叠分数来估计跟踪器的性能。在大多数情况下,这两个数字对跟踪器评估[28]比较公平。重叠分数是基于[40]的工作,仅使用公式score=area(〖ROI〗_T∩〖ROI〗_G)/area(〖ROI〗_T∪〖ROI〗_G)对边界框进行计算得到评估值。在实验中,区域(〖ROI〗_T)是来自跟踪器的结果边界框的区域,而区域(〖ROI〗_G)是真实结果的区域。中心位置误差是跟踪器结果边界框的中心点与真值框中心点之间的欧氏距离。

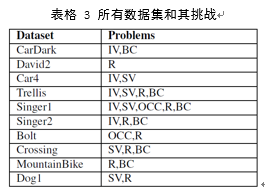

为了测试每个跟踪器的鲁棒性,采用称为单次通过评估的方法。它是用来测试目标跟踪鲁棒性的最常规方式。在这个方法中,首先记录中心位置误差的平均值以及重叠得分,然后采用两个评估度量,第一个计算具有比给定阈值更高的重叠分数的帧的百分比,而第二个计算具有比给定阈值更小的中心位置误差的帧的百分比。这些度量将生成两个数字,而随着阈值的变化可以得到两张曲线图如图4。在图4中有上面所说的所有10个数据集和11个跟踪方法的两个指标的AUC。两张图中的更高的曲线意味着在所有序列中更好的性能。

7.1 在线AMAM方法和原AMAM方法

在前面的章节中,我们比较了我们的新的跟踪方法和AMAM跟踪方法[41]。由于在线方法在长期跟踪目标的预测速度方面存在优势,我们比较这两种方法在时间消耗。图4(a)展示了对于OAMAM方法和AMAM方法的网格中的每个帧的DPMM时间消耗。很明显,AMAM方法在跟踪很长一段时间之后有一个相当难以承受的时间成本,而我们的在线方法执行相对稳定。

除了时间成本,他们在跟踪任务期间形成外观模型有轻微的差异。 图4(b)示出了在数据集Trellis中的每个帧下的两种方法的外观模型的数量。

7.2 定性&定量比较

我们在上面介绍的10个视频序列上运行这些需要进行对比的跟踪器和我们提出的跟踪器(这些视频序列在前面的章节中也称为数据集)。跟踪器跟踪到的一些关键帧和结果边界框如图3所示。

当背景与对象具有相似的颜色或纹理时,我们的跟踪器具有强大的性能。典型的背景干扰问题可以在MountainBike,Crossing中找到。在图3的Crossing数据集中,当汽车通过行人附近时,他们在第31帧中有类似的暗色,并导致ASLA,Struck和TLD跟丢了目标。在第73帧到第85帧中,目标行人自己的影子对本身产生的干扰,此时只有Struck,MIL和我们的跟踪器成功地捕获目标(但是Struck不能跟踪第31帧中的行人)。在MountainBike中,我们的跟踪器在目标位于草地或暗色调中如,第62帧(VTD完全从该帧丢失目标),帧150,帧199和帧225仍然表现良好。在这两个视频的整个时段序列,我们的跟踪器完美跟踪目标,并比其他跟踪器的效果更好。

由于视频序列Bolt,David2的目标旋转了,故其中这些序列呈现旋转挑战。在Bolt中,在图3所示的第一个帧(帧:97)中,Bolt朝向相机运行,在第二个帧(帧:137)中,Bolt平行于相机运行。虽然大多数跟踪器在帧97中丢失其目标,但是四个跟踪器仍然捕获了Bolt。但是在框架137中,只有其中三个成功捕获对象,其中IVT跟丢了Bolt,而在帧252中,几乎所有其他跟踪器的边界框几乎不与目标重叠。在所有的整个视频Bolt中,我们的跟踪器有一个稳定的性能。此外,在David2中存在丰富的平面旋转和立体旋转,在帧79到115中,目标对象做出平面旋转,在该时间段期间,一半跟踪器跟丢了面部目标。虽然大多数跟踪器最后都成功地跟踪面部,但是它们由于中间跟丢了一段时间而不能根据图3如此精确地跟踪。

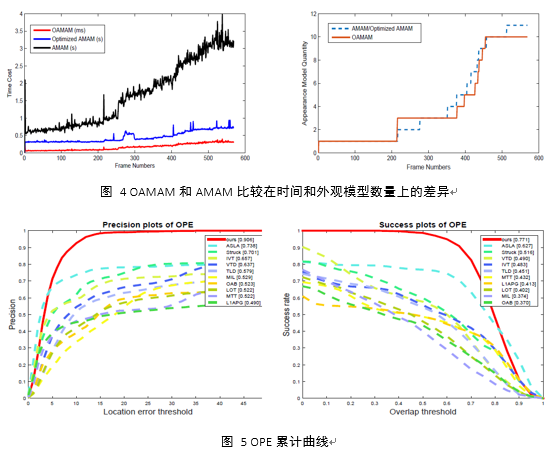

我们使用上面的方案完成了比较和分析所有的数据后评价。通过采用OPE的方式评估,我们将所有测试数据集中跟踪器的性能与图6所示的相同测试结果进行比较。从图5,我们发现我们的跟踪方法在这些10个数据集的OPE评估中胜过其他最先进的方法。在图表中,我们还可以得出我们的跟踪方法比第二优的跟踪方法好大约16%。

8. 结论

在本文中,我们提出了一个新的在线自适应多出现模型的长期跟踪。这种方法保留了追踪目标的外观的更多历史信息,以避免在通过改变照明或目标姿势改变导致的追踪期间目标漂移或丢失。我们使用HOG在我们的算法框架中构建跟踪目标的基本外观表示。并多次使用在线顺序逼近BNP学习方法无监督和动态地分组。接着使用NOR方法从跟踪器基于这些外观模型预测的候选目标中选择跟踪结果。在几个公开数据集中的实验表明,对比现有先进方法,我们的跟踪器具有低变化率(小于0.002),实时跟踪的低时间成本和高跟踪性能(平均比其他10个跟踪器高16%)。

9. 参考文献

[1] D. Comaniciu, V. R. Member, and P. Meer, "Kernel-basedobject tracking," IEEE Trans. Pattern Anal. Mach. Intell., vol.25, no. 5,pp. 564-575, May 2003.

[2] P. P?l?erez, C. Hue, J. Vermaak, and M. Gangnet, "Color-based probabilistic tracking," in Proc. Eur. Conf. Comput. Vis.,2002, pp. 661-675.

[3] Y. Li, H. Ai, T. Yamashita, S. Lao, and M. Kawade, "Tracking in low frame rate video: A cascade particle filter with discriminative observers of different life spans," IEEE Trans.Pattern Anal. Mach. Intell., vol. 30, no. 10, pp. 1728-1740,Oct. 2008.

[4] S. AN and D. AN. Stochastic relaxation, Gibbs distributions,and the Bayesian restoration of images. IEEE Trans. Pattern Anal. Machine Intell, 6:721-741, 1984. 1

[5] D. M. Blei and M. I. Jordan. Variational inference for dirichlet process mixtures. Bayesian Analysis, 1:121-144, 2005.1

[6] D.Lin. Online Learning of Nonparametric Mixture Models via Sequential Variational Approximation. Proc. NIPS, 2013

[7] C. Stauffer andW. E. L. Grimson. Adaptive background mixture models for real-time tracking. In Computer Vision and Pattern Recognition, 1999. IEEE Computer Society Conference on., volume 2, pages 246-252 Vol. 2, Los Alamitos, CA, USA, Aug. 1999. IEEE. 1, 3

[8] Y. Ulker, B. Gunsel, and A. T. Cemgil. Sequential monte carlo samplers for dirichlet process mixtures. In AISTATS’10, 2010. 1, 3

[9] D. G. Lowe. Object recognition from local scale-invariant features. Proc. ICCV, pages 1150-1157, 1999.

[10] Ferguson, T. (1973), "A Bayesian Analysis of Some Nonparametric Problems," Annals of Statistics,1(2), pp.209-230.

[11] A. Yilmaz, O. Javed, and M. Shah, "Object tracking: A survey," ACM Comput. Surveys, vol. 38, no. 4, pp. 1-45, 2006.

[12] K. Cannons, "A review of visual tracking, " Dept. Comput. Sci., York Univ., Toronto, ON, Canada, Tech. Rep. CSE-2008-07, 2008.

[13] A. D. Jepson, D. J. Fleet, and T. F. El-Maraghi, "Robust online appearance models for visual tracking," IEEE Trans. Pattern Anal. Mach. Intell., vol. 25, no. 10, pp. 1296-1311, Oct. 2003.

[14] Ma B, Shen J, Liu Y, et al. Visual tracking using strong classifier and structural local sparse descriptors[J].

Multimedia, IEEE Transactions on, 2015, 17(10): 1818-1828.

[15] D. Ross, J. Lim, R.-S. Lin, M.-H. Yang, Incremental learning for robust visual tracking, IJCV 77 (1-3) (2008) 125-141.

[16] B. Babenko, M.-H. Yang, S. Belongie, Visual tracking with online multiple instance learning, CVPR, 2009, pp. 983-990.

[17] S. Avidan, Ensemble tracking, PAMI 29 (2) (2007) 261-271.

[18] Hong E, Bae J, Lim J. Robust visual tracking through deep learning-based confidence evaluation[C] //Ubiquitous Robots and Ambient Intelligence (URAI), 2015 12th International Conference on. IEEE, 2015: 581-584.

[19] Pitman J. Combinatorial stochastic processes. Lecture Notes in Mathematics 1875. Berlin: Springer-Verlag, 2006

[20] Xu, Chao, et al. "Robust visual tracking via online multiple instance learning with Fisher information." Pattern Recognition 48.12 (2015): 3917-3926.

[21] P. Viola, J.C. Platt, and C. Zhang, "Multiple Instance Boosting for Object Detection," Proc. Neural Information Processing Systems, pp. 1417-1426, 2005.

[22] M. Isard and A. Blake, "CONDENSATION-Conditional density propagation for visual tracking," Int. J. Comput. Vis., vol. 29, no. 1,pp. 5-28, 1998.

[23] J. M. Bernardo and A. F. M. Smith. Bayesian Theory. Wiley, 1994.

[24] Bissacco, Alessandro, M. Yang, and Stefano Soatto. "Detecting humans via their pose." Advances in Neural

Information Processing Systems 19 (2007): 169.

[25] Manandhar A, Morton Jr K D, Collins L M, et al. A nonparametric bayesian approach to multiple instance

learning[J]. International Journal of Pattern Recognition and Artificial Intelligence, 2015, 29(03): 1551001.

[26] Jia,X., Lu,H., and Yang,M.: Visual Tracking via Adaptive Structural Local Sparse Appearance Model. In CVPR(2012).

[27] Zuo W, Wu X, Lin L, et al. Learning Support Correlation Filters for Visual Tracking[J]. arXiv preprint

arXiv:1601.06032, 2016.

[28] Wu,Y., Lim,J., Yang,M.,: Online Object Tracking: A Benchmark, In Proc. IEEE Conference on Computer Vision and Pattern Recognition(CVPR), pp.2411-2418(2013).

[29] Babenko,B., Yang,M., Belongie,S.: Robust Object Tracking with Online Multiple Instance Learning, IEEE Transactions on Pattern AnalysisMachine Intelligence(TPAMI),33(8):1619-1632(2011).

[30] Zhang, Tianzhu, et al. "Robust visual tracking via consistent low-rank sparse learning." International Journal of Computer Vision 111.2 (2015): 171-190.

[31] Oron,S., Bar-Hillel,A., Levi,D., and Avidan,S.: Locally Orderless Tracking. In CVPR, (2012).

[32] Ross,D., Lim,J., Lin,R., Yang,M.: Incremental Learning for Robust Visual Tracking. IJCV, 77(1):125-141(2008).

[33] Kristan, Matej, et al. "The Visual Object Tracking VOT2015 Challenge Results." Proceedings of the IEEE International Conference on Computer Vision Workshops. 2015.

[34] Kwon,J. and Lee,K.M.,: Visual Tracking Decomposition. In CVPR(2010).

[35] Bao,C., Wu,Y., Ling,H., and Ji,H.: Real Time Robust L1 Tracker Using Accelerated Proximal Gradient Approach. In CVPR(2012).

[36] Grabner,H., Grabner,M., and Bischof,H.: Real-Time Tracking via Online Boosting. In BMVC(2006).

[37] Wang, Naiyan, et al. "Understanding and diagnosing visual tracking systems." Proceedings of the IEEE International Conference on Computer Vision. 2015.

[38] Hare,S., Saffari,A. and Struck,P.H.S.Torr.: Structured Output Tracking with Kernels. In ICCV(2011).

[39] Zhang,T., Ghanem,B., Liu,S., Ahuja,N.: RobustVisualTracking via Multi-task Sparse Learning. In CVPR(2012).

[40] Everingham M, Van Gool L, Williams C K I, et al. The pascal visual object classes (voc) challenge[J]. International journal of computer vision, 2010, 88(2): 303-338.

[41] Shuo Tang, Longfei Zhang, Jiapeng Chi, Zhufan Wang, and Gangyi Ding.: Adaptive Multiple Appearances Model framework for Long-term Robust Tracking. In PCM(2015).

|

分享让更多人看到

推荐阅读

相关新闻

- 评论

- 关注

第一时间为您推送权威资讯

第一时间为您推送权威资讯

报道全球 传播中国

报道全球 传播中国

关注人民网,传播正能量

关注人民网,传播正能量