基于评论的个性化评分预测

【摘要】: 如今,用户和商品之间的在线互动变得多样化,包括文本评论和数字评分。评论表达了各种意见和观点,可以在一定程度上消除推荐的稀疏性问题。在本文中,我们讨论基于个性化基于评论的预测问题,即利用用户的历史评论和相应的评级来预测他们未来要买的物品的评分。虽然很多人都致力于解决这一挑战问题,主要是为了研究如何对自然文本和用户个性化进行建模,但大多数人忽略了隐藏在用户评论和评分序列中的连续特征。为了解决这个问题,我们提出了一种新颖的基于混合评论的顺序模型来捕捉用户和物品的信息。这是通过将用户和物品的序列提供给捕获动态的长短期记忆(LSTM)神经网络来实现的,除此之外,我们还利用基于传统的低秩因子分解获得的用户表示以及物品表示。在实际公共数据集的实验结果表明,我们的模型优于其他比较模型。

【关键词】: 推荐系统, 评级预测, 评估分析, 时序模型

1 简介

随着互联网的快速发展,每天都会涌现出大量的信息,带来机遇和挑战。 在许多采用的技术中,推荐系统一直扮演着越来越重要的角色,有利于减轻普通用户的信息过载并增加电子商务公司的销售。 特别是在推荐系统领域,评分预测是一个基本问题,自Net?ix Prize Competition1的成功以来备受关注。 给定历史评分,需要评分预测来预测用户对之前未评估的物品的评分。隐因子模型 [5] [9] [10] 表现良好,广泛应用于评分预测问题。这些模型的主要目标是为用户和物品学习低维表示,反映它们的接近程度。Salakhutdinov等 [9] 从概率的角度出发,首先提出了因子模型。除了基本的隐因子模型,Koren等人[4] 引入了额外的用户和物评分偏移用来提高预测性能。 如今,用户和商品之间的在线互动变得多样化,其中包括除了评分之外的文本评论。 根据[10] ,评论信息作为一种辅助信息的评论对于推荐系统是有价值的。

基于评论的评分预测问题在隐因子主题(HFT)[7] 的模型中得到很好的阐述,旨在利用来自普遍存在的评论的知识来提高评分预测性能。由于评论可以被视为用户和物品之间的交互,因此它们包含与用户和物品潜在因素相关的信息。目前该问题的解决方案可分为两种方式。一种是使用主题模型根据他们的评论文本[7] [1] [2] [6] [11] 为用户和物品生成隐因子。另一种方法是利用新的神经网络对评论文本中的单词或句子的语义表示进行建模[12] [14] 。然而,目前大多数基于评论的模型主要侧重于学习评论的语义表示,忽略评论中的时序特征,这是我们论文要解决的内容。另外,基于评论的评分预测任务与情绪分类的任务不同。我们的任务重点是利用用户的历史评论和相应的评分来预测他们之前未购买的评分。但是,情感分类任务是对当前的文本评论情绪进行分类,其学习语义表示的方法可以在我们任务的基本组成部分中引用。

为了突出我们提出的模型的区别,我们首先介绍了简要考虑时间维度的时序模型。 由于用户的偏好倾向于随时间变化并且受到新商品的影响,因此时序交互历史作为一种类似于[10] 中提到的评论的辅助信息,可能成为预测评级的重要因素。 除了用户之外,项目的特征也可能受到最近评分用户的影响。 然而,基于矩阵分解[15] 或深度神经网络[13] 的现有方法主要用于挖掘评分的时间信息,因此它们不能直接用于对评论中的时序特征进行建模。

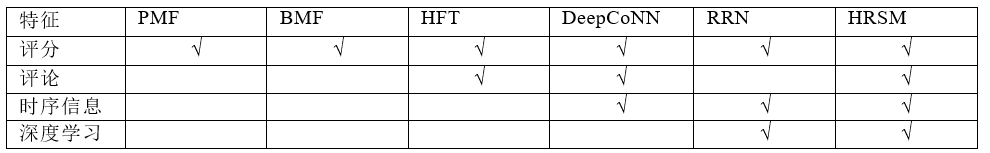

从上面的介绍中,我们发现大多数当前基于评论的模型和序列模型只考虑评论信息或时间信息。 为了解决这个问题,我们提出了一种新颖的基于评论的顺序模型(HRSM)来捕捉用户和物品的交互信息。 隐藏在文本评论中的时序信息可以帮助我们揭示用户偏好和物品特征的动态变化。 在我们提出的模型中同时捕获这两种辅助信息,即评论和时间性。 此外,由隐因子模型生成的用户和项目的固定隐因子可能在很长一段时间内保持固有特征。 我们将这些静止状态与用户和物品集成在一起。从评论序列中学习动态状态以共同预测评分。 我们提出的模型与评分预测任务中的代表性模型之间的关键差异,包括PMF [9] ,BMF [4] ,HFT [7] ,DeepCoNN [14] ,RRN[13] ,总结在表1中。

表 1:不同模型的对比

总之,我们工作的主要贡献如下:

我们提出了一种基于评论的评分时序预测模型,通过利用其历史评论,可以捕捉用户和项目的时间动态;

我们将用户和项目的固有隐状态表示与动态状态相结合,从时序文本序列学习从而能够共同与测评分;

对真实公共数据集进行的大量实验表明,我们的模型优于最先进的基准模型,并且明显受益于采用时序评论内容。

2 前期准备:

2.1 问题定义

假设用户集和项集分别表示为U和V. 我们进一步将评级矩阵表示为R,将评论文本的集合表示为D.对于u∈U和v∈V,ruv∈R表示用户u分配给项目v的评级值,而duv∈D表示 由用户u写入项目v的相应评论文本。给定历史已知评级和评论,基于个性化评论的评分预测的问题是预测评分矩阵R中的缺失评分值。

2.2 偏向矩阵分解(BMF)

为了验证时序信息和评论文本的工作原理,我们首先简要介绍一个静态模型。 偏向矩阵分解(BMF)[4] 是推荐系统的协同过滤模型。 它是在各种场景中应用的经典的基准模型。 用户u对项目v的预测评级![]() 可以计算为:

可以计算为:

其中,Pu 和qv为用户与物品的静态隐状态表示,bu和bu为他们的偏移量,g一般是评分的平均分。

3 模型框架

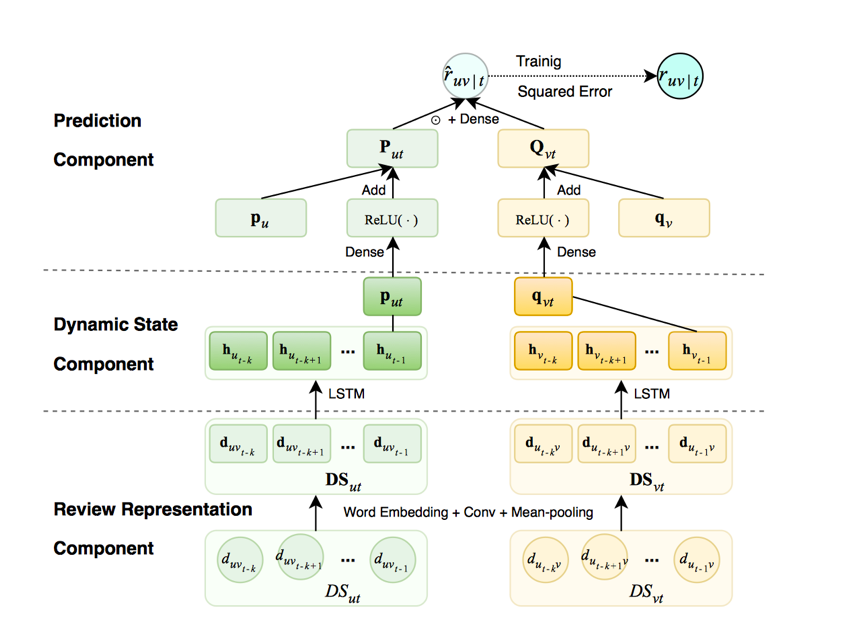

图 1模型框架

在本文中,我们提出了一种新的基于评论的时序模型(HRSM)。 我们提出的模型的总体框架如图1所示。具体而言,我们首先通过逐步将其内部单词提供给CNN来获得每个评论的表示。 然后使用LSTM [3] 对评论序列的时序属性进行建模,从而获得用户和物品的动态状态。 我们进一步将动态状态与用户和物品固定隐向量相结合,以进行最终评分预测。

3.1 评论表示

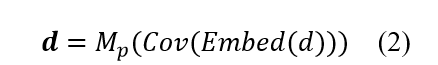

众所周知,评论包含丰富的信息。 评论中的情感词语,例如正面或负面词语,表示用户对物品所显示的偏好。 在探索评论之间的时序关系之前,我们首先需要获得每个给定评论的表示。 每个评论![]() 由一定数量的单词组成,其中每个单词w∈W来自词汇表W。在进行与处理的时候,可以在评论填充零保持句式等长性,每个评论都可以转换为固定长度的矩阵,每个单词都有原始的表示。 在通过Embedding层转换之后,评论内的每个单词被表示为嵌入w。 对于每个评论,我们采用卷积层来提取局部特征,然后采用均值池来对其内部词进行平均局部特征。 最后,输出向量d被视为当前输入评论的表示。

由一定数量的单词组成,其中每个单词w∈W来自词汇表W。在进行与处理的时候,可以在评论填充零保持句式等长性,每个评论都可以转换为固定长度的矩阵,每个单词都有原始的表示。 在通过Embedding层转换之后,评论内的每个单词被表示为嵌入w。 对于每个评论,我们采用卷积层来提取局部特征,然后采用均值池来对其内部词进行平均局部特征。 最后,输出向量d被视为当前输入评论的表示。

上述过程可以表述如下:

其中,Embed表示词嵌入过程,Cov表示卷积神经网络,Mp表示平均池化层。

我们注意到,还可以应用LSTM图层来学习相关工作部分中提及的评论表示。 但是在以下过程中,我们使用另一个LSTM层来对查看序列进行建模。 由这两种LSTM层组成的嵌套结构将使整个模型过于复杂,在试图试验中表现良好。 因此,我们选择CNN层作为替代方案。

3.2 基于评论的用户与物品的隐状态学习

因为以类似的方式学习基于他们的评论来学习用户和物品的动态状态表示的过程,所以我们仅仅说明如何为用户更详细地建立基于评论的状态的模型。 为了模拟用户的动态状态,我们应该考虑评论的时间戳。

假设当前用户已经与n个物品进行了交互。在按时间戳排序交互后,我们得到一个项目编号序列,表示为![]() 和一个表示为评论序列

和一个表示为评论序列![]() 。与以往的研究内容不同的是: 我们根据评论序列

。与以往的研究内容不同的是: 我们根据评论序列![]() 而不是物品序列

而不是物品序列![]() 来模拟用户用户u的动态变化,因为评论表示当前用户u和其他项目之间的相互关系,并且倾向于包含用户的倾向以及物品的特征。对于用户u以及物品v在时间t的状态,它们的评分表示为

来模拟用户用户u的动态变化,因为评论表示当前用户u和其他项目之间的相互关系,并且倾向于包含用户的倾向以及物品的特征。对于用户u以及物品v在时间t的状态,它们的评分表示为![]() 。 显然,

。 显然,![]() 仅与t之前的相互作用相关联。 对于评分

仅与t之前的相互作用相关联。 对于评分![]() ,由u指定的最新k个相互作用(v本身被排除)由

,由u指定的最新k个相互作用(v本身被排除)由![]() 的子序列组成,表示为

的子序列组成,表示为![]() 。在经过Embed层后,时序的评论信息被嵌入到低维的向量空间表示为

。在经过Embed层后,时序的评论信息被嵌入到低维的向量空间表示为![]() 其中l表示评论向量的维度,k 表示序列长度或者窗口的大小。当时间窗口在整个时序序列

其中l表示评论向量的维度,k 表示序列长度或者窗口的大小。当时间窗口在整个时序序列![]() 上保持滑动时,生成多个

上保持滑动时,生成多个![]() ,其被视为LSTM层的输入实例。 为了使LSTM的输入序列具有相同的长度,我们假设当前要预测的每个评级明确地来自其最新的k个相互作用。 对于静态模型,我们通过公式1中所示的矩阵分解来获得用户和项目的静态状态。 不同于之前的模型,对于时序模型,我们应用LSTM [6]从其评论序列中学习用户的动态状态。 在序列

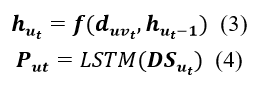

,其被视为LSTM层的输入实例。 为了使LSTM的输入序列具有相同的长度,我们假设当前要预测的每个评级明确地来自其最新的k个相互作用。 对于静态模型,我们通过公式1中所示的矩阵分解来获得用户和项目的静态状态。 不同于之前的模型,对于时序模型,我们应用LSTM [6]从其评论序列中学习用户的动态状态。 在序列![]() 的每个时间步骤t,LSTM的隐藏状态

的每个时间步骤t,LSTM的隐藏状态![]() 的更新基于当前的评论表示

的更新基于当前的评论表示![]() 和先前隐藏的状态

和先前隐藏的状态![]() 通过某个函数f来更新。这种关系是用公式3表达的。 函数f内的三个门,即输入门,忘记门和输出门,协同控制信息如何通过序列传播。 以这种方式,整个评论序列中的每个评论被一起考虑,因为当隐藏状态通过序列传播时,当前评论可以影响所有后续评论。 当我们将序列

通过某个函数f来更新。这种关系是用公式3表达的。 函数f内的三个门,即输入门,忘记门和输出门,协同控制信息如何通过序列传播。 以这种方式,整个评论序列中的每个评论被一起考虑,因为当隐藏状态通过序列传播时,当前评论可以影响所有后续评论。 当我们将序列![]() 馈送到LSTM层时,转换函数f总共进行k次。 我们基于其最近的审查序列获得最后隐藏状态作为用户动态状态表示

馈送到LSTM层时,转换函数f总共进行k次。 我们基于其最近的审查序列获得最后隐藏状态作为用户动态状态表示![]() ,其计算方式见公式4。

,其计算方式见公式4。

以类似的方式,对于当前物品v,我们可以获得由m个用户写的评论组成的评论序列![]() ,对于

,对于![]() ,物品 v也有一个子序列

,物品 v也有一个子序列![]() 。 请注意,根据定义,尽管

。 请注意,根据定义,尽管![]() 和

和![]() 的长度相同,但它们的评论文档并不完全相同。 在应用LSTM层之后,我们还可以基于其查看序列获得项v的动态

的长度相同,但它们的评论文档并不完全相同。 在应用LSTM层之后,我们还可以基于其查看序列获得项v的动态![]()

3.3 联合评分预测

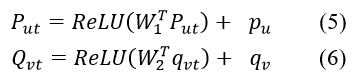

到目前为止,我们已经根据他们的评论顺序获得了用户和物品的动态状态。 值得注意的是,用户和物品都具有一些不随时间变化的固有特征。 例如,用户具有固定的性别,并且物品具有稳定的外观。 因此,将动态和静态状态组合在一起进行评分预测是必要的。 具体而言,我们引入了一个完全连接层,它由一个权重矩阵W1 (作为参数包括的偏差)和一个ReLU激活函数[8] 组成,以将动态状态映射到与静止状态相同的向量空间。 我们用如下的公式表示用户和物品的最终状态:

以前的工作如BMF [10]比如公式(1),简单地进行两个隐向量的点积,以产生标量作为预测评级。 在这种情况下,用户和项目的潜在向量中的不同维度被认为是同等重要的。 为了改进泛化,使用权重矩阵W_3进行线性变换以区分显着的尺寸。 最后,我们的模型采用以下等式来预测评级![]() :

:

![]()

其中,⊙表示表示两个向量的元素乘积。

3.4 损失函数

我们通过最小化预测和真实预测值之间的正则化平方误差损失来定义我们的目标函数:

![]()

其中Reg(θ)表示对模型参数做正则化。

4 实验

在本节中,我们将描述我们的实验设置并对实验结果进行详细分析。

4.1 数据集

我们基于亚马逊数据集进行实验。我们通常采用两个大的子集:“CDs and Vinyl” (hereinafter called CD)(以下称为CD)和“Movies and TV”(以下称为电影)。 CD数据集与音频术语更相关,而Movie数据集与视频术语更相关。

为了获得足够的序列实例,我们删除数据集上出现次数少于20次的用户和项目。在过滤之后,CD和电影数据集上的总交互(评分或评论)仍分别超过〖10〗^5和4×105。详细摘要显示在表2中。由于我们的序列模型将历史评论作为输入,为了确保与其他固定模型的公平比较,测试集使用每个用户的最后评分构建,其他项目构成训练集。此外,我们使用相同的策略对训练集进行分区以获得验证集,该验证集用于调整超参数。均方误差(MSE)被用作用于测量模型性能的评估度量。

表 2 数据集基本信息

![]()

4.2 基准模型

我们的模型HRSM与三种传统模型和三种最先进的模型进行了比较,包括GloAvg,PMF,BMF,HFT,DeepCoNN和RRN。 具体而言,前三种方法使用数字评级,以下两种方法学习主题模型或神经网络的评论表示,最后一种方法吸收时间信息。 表1总结了比较方法(不包括GloAvg)的不同之处。

? GloAvg。 GloAvg只使用公式(1)中的全局因子g进行预测。

? PMF [9] 。 PMF从概率上计算矩阵分解,没有评分偏见。

? BMF[4] 。 BMF使用矩阵分解考虑额外的用户和物品在PMF基础上的偏移。

? HFT [7] 。 HFT是将评论与评分相结合的经典方法。 它将矩阵分解与主题模型相结合,前者学习潜因素,后者学习评论参数。

? DeepCoNN [14] 。 这是基于评论的评分预测问题的最先进方法,其无法区分地将每个用户或项目的所有评论合并到新的大文档中,然后使用CNN来学习评论表示。

? RRN [13] 。 这是用于评分预测问题的最先进的顺序模型,其使用LSTM通过对用户和物品的编号序列建模而不考虑评论来捕获动态。

4.3 超参数设置

我们的模型在Keras 中实现,这是一个高级神经网络API框架。 我们使用Adam 来优化神经网络参数。 为了获得我们模型和比较基线的稳健性能,我们用不同的种子初始化每个模型,并重复实验五次,并使用它们的平均结果并使用网格搜索在验证集中调整超参数。 我们这是向量的维度为40 。 单词的向量长度是100,LSTM的维度大小为40 。 批量大小设置为256,学习率设置为0.001。 我们使用L2正则化,其参数在CD数据集上设置为![]() ,而在Movie数据集上设置为

,而在Movie数据集上设置为![]() 。

。

4.4 结果分析

两个数据集上的模型的性能在表3中。从结果中,我们得到以下观察:(1)GloAvg是最弱的模型,因为它是一种非个性化的方法。与PMF相比,BMF在引入额外的评分偏差表现更好。 (2)除了使用评分矩阵的PMF和BMF之外,以下三种方法(HFT,DeepCoNN和RRN)考虑其他信息,如文本评论或时序属性,通常获得更好的结果。 RRN在Movie数据集上表现不佳,原因可能是该数据集在用户和物品的序列中具有较稀疏的信息。 (3)RRN和DeepCoNN分别是CD和Movie数据集的最好的效果。它表明利用深度神经网络的方法通常比其他基准模型表现更好。 (4)我们的模型HRSM一直优于两个数据集的所有基线。 HRSM和RRN都是考虑序列信息的深度神经网络,但HRSM的结果更好,这表明评论信息是对评级的补充。虽然HRSM和DeepCoNN都是考虑文本评论的深度神经网络,但我们的模型由于利用了时序信息而表现更好。

5 结论

在本文中,我们提出了一种新的时序预测模型,用于基于个性化评论的评分预测问题。以前的模型考虑评论信息或时间信息,但是在我们提出的模型中同时捕获了这两种信息。 利用深度神经网络,我们的模型通过利用其评论序列中包含的时序属性来学习用户和物品的动态特征。 实际公共数据集的实验结果证明了我们提出的模型的有效性,并证明隐藏在评论中的时序属性在评分预测任务中起了很大作用。

References:

[1] Bao, Y., Fang, H., Zhang, J.: Topicmf: Simultaneously exploiting ratings and re- views for recommendation. In: Proceedings of the Twenty-Eighth AAAI Conference on Arti?cial Intelligence. pp. 2–8 (2014)

[2] Diao, Q., Qiu, M., Wu, C.Y., Smola, A.J., Jiang, J., Wang, C.: Jointly modeling aspects, ratings and sentiments for movie recommendation (jmars). In: Proceedings of the 20th ACM SIGKDD International Conference on Knowledge Discovery and Data Mining. pp. 193–202 (2014)

[3] Hochreiter, S., Schmidhuber, J.: Long short-term memory. Neural Comput. 9(8), 1735–1780 (Nov 1997)

[4] Koren, Y., Bell, R., Volinsky, C.: Matrix factorization techniques for recommender systems. Computer 42(8), 30–37 (Aug 2009)

[5] Lee, D.D., Seung, H.S.: Algorithms for non-negative matrix factorization. In: NIPS. pp. 535–541 (2000)

[6] Ling, G., Lyu, M.R., King, I.: Ratings meet reviews, a combined approach to rec- ommend. In: Proceedings of the 8th ACM Conference on Recommender Systems. pp. 105–112 (2014)

[7] McAuley, J., Leskovec, J.: Hidden factors and hidden topics: Understanding rat- ing dimensions with review text. In: Proceedings of the 7th ACM Conference on Recommender Systems. pp. 165–172 (2013)

[8] Nair, V., Hinton, G.E.: Recti?ed linear units improve restricted boltzmann ma- chines. In: Proceedings of the 27th International Conference on International Con- ference on Machine Learning. pp. 807–814 (2010)

[9] Salakhutdinov, R., Mnih, A.: Probabilistic matrix factorization. In: NIPS. pp. 1257–1264 (2007)

[10] Shi, Y., Larson, M., Hanjalic, A.: Collaborative ?ltering beyond the user-item matrix: A survey of the state of the art and future challenges. ACM Comput. Surv. 47(1), 3:1–3:45 (May 2014)

[11] Tan, Y., Zhang, M., Liu, Y., Ma, S.: Rating-boosted latent topics: Understanding users and items with ratings and reviews. In: IJCAI. pp. 2640–2646 (2016)

[12] Wang, H., Wang, N., Yeung, D.Y.: Collaborative deep learning for recommender systems. In: Proceedings of the 21th ACM SIGKDD International Conference on Knowledge Discovery and Data Mining. pp. 1235–1244 (2015)

[13] Wu, C.Y., Ahmed, A., Beutel, A., Smola, A.J., Jing, H.: Recurrent recommender networks. In: WSDM. pp. 495–503 (2017)

[14] Zheng, L., Noroozi, V., Yu, P.S.: Joint deep modeling of users and items using reviews for recommendation. In: WSDM. pp. 425–434 (2017)

[15] Koren, Y.: Collaborative ?ltering with temporal dynamics. In: Proceedings of the 15th ACM SIGKDD International Conference on Knowledge Discovery and Data Mining. pp. 447–456 (2009)

分享让更多人看到

推荐阅读

相关新闻

- 评论

- 关注

第一时间为您推送权威资讯

第一时间为您推送权威资讯

报道全球 传播中国

报道全球 传播中国

关注人民网,传播正能量

关注人民网,传播正能量